หากคุณกำลังมองหาวิธีทำให้ SEO ติดหน้าแรก การจัดการด้าน Technical SEO ถือเป็นสิ่งที่ขาดไม่ได้ โดยเฉพาะการตั้งค่า robots.txt อย่างถูกต้อง robots.txt คือไฟล์ที่ช่วยบอก Search Engine ว่าควรเก็บข้อมูลส่วนไหนของเว็บไซต์บ้าง ทำให้ Google เข้าใจเนื้อหาเว็บไซต์ของคุณได้ดีขึ้นและช่วยเพิ่มโอกาสในการติดอันดับบน Google SERPs ได้ ANGA Mastery จะพาคุณไปทำความรู้จัก robots.txt อย่างลึกซึ้ง ทั้งความสำคัญ ข้อดี ข้อควรระวัง วิธีสร้าง วิธีตรวจสอบ ไปจนถึงคำสั่งและสคริปต์ที่คุณไม่ควรพลาด ใครที่กำลังมองหาคอร์สเรียนการตลาดที่เจาะลึกเรื่องนี้อยู่ ลองมาอ่านบทความนี้ดูก่อน ถ้าอยากรู้เรื่องการทำ SEO ในเชิงที่ลึกขึ้นก็สามารถลงคอร์สเรียน SEO เพิ่มเติมได้

Table of Contents

robots.txt คืออะไร

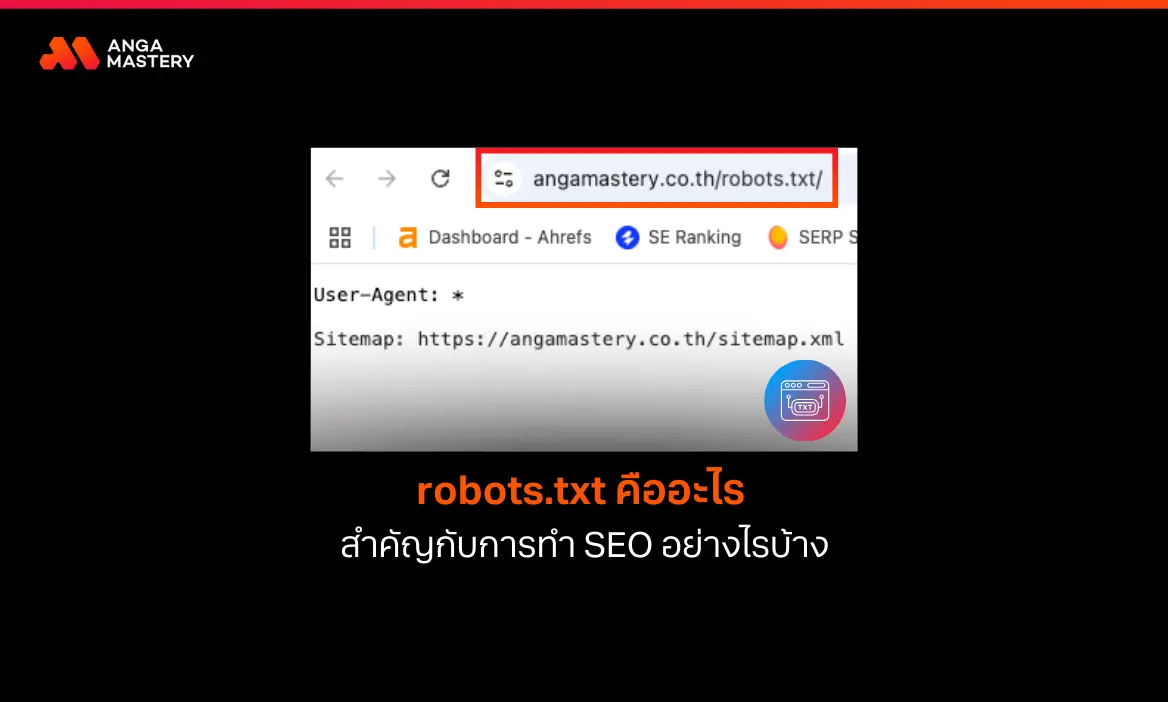

robots.txt คือไฟล์พิเศษที่ถูกจัดเก็บไว้ในโฟลเดอร์หลัก (Root Directory) มีลักษณะเป็นไฟล์ข้อความหรือสคริปต์ มีหน้าที่ในการกำหนดคำสั่งและระบุข้อจำกัดให้แก่ Search Engine Bot หรือที่เราคุ้นเคยกันอย่าง Googlebot ซึ่งเราระบุได้ว่า Googlebot สามารถเข้าถึงและเก็บข้อมูลจากส่วนใดบนเว็บไซต์ได้บ้าง รวมถึงสามารถระบุได้ว่าส่วนในที่ไม่ต้องการให้ Googlebot เข้าไปเก็บข้อมูลบ้าง

เมื่อ Googlebot เข้ามาที่เว็บไซต์ จะทำการตรวจสอบไฟล์ robots.txt ก่อนเป็นอันดับแรก เพื่ออ่านคำสั่งและพิจารณาว่าควรเก็บข้อมูลจากส่วนใดบ้าง ทั้งนี้ robots.txt ไม่ได้ใช้ทำให้ Google ไม่ดึงเอาหน้าเว็บของเราไปแสดงผลบน Google Search แต่อย่างใด ถ้าคุณต้องการไม่ให้หน้าเว็บแสดงบนผลการค้นหา แนะนำให้ใช้คำสั่ง noindex เพื่อสั่งไม่ให้จัดทำดัชนีแทน

robots.txt ใช้ทำอะไร สำคัญกับ SEO อย่างไร

robots.txt เป็นเครื่องมือสำคัญในการจัดการวิธีที่ Search Engine Bot เข้าถึงและรวบรวมข้อมูลจากเว็บไซต์ของคุณ โดยปกติแล้ว Bot จะเข้ามาค้นหาและจัดทำดัชนีข้อมูลทุกส่วนของเว็บไซต์โดยอัตโนมัติ การใช้ robots.txt ช่วยให้คุณควบคุมส่วนที่ต้องการให้ Bot เข้าถึงได้ และส่วนที่ควรจำกัดการเข้าถึง เช่น ข้อมูลส่วนตัวของสมาชิก หน้าแอดมิน หรือเอกสารภายในองค์กร

ถ้าถามว่า robots.txt สำคัญกับการทำ SEO (Search Engine Optimization) ไหม? บอกเลยว่าสำคัญมาก เพราะมันช่วยให้เว็บไซต์ของคุณได้รับการจัดอันดับในตำแหน่งที่ดีขึ้นได้ด้วยการจัดการทรัพยากรอย่างมีประสิทธิภาพ เมื่อคุณกำหนดให้ Bot เข้าถึงเฉพาะหน้าที่สำคัญและมีคุณภาพ จะทำให้ Google เข้าใจเนื้อหาหลักของเว็บไซต์ได้ชัดเจนขึ้น ไม่สับสนกับเนื้อหาที่ไม่เกี่ยวข้องหรือซ้ำซ้อน ส่งผลให้เว็บไซต์มีโอกาสติดอันดับต้น ๆ ในผลการค้นหามากขึ้นนั่นเอง

นอกจากนี้ robots.txt ยังช่วยบริหาร Crawl Budget ให้เกิดประโยชน์สูงสุดด้วย โดย Crawl Budget คือจำนวนหน้าที่ Bot สามารถเข้าถึงและประมวลผลได้ในแต่ละวัน เว็บไซต์ขนาดใหญ่ที่มีหน้าเพจจำนวนมากจำเป็นต้องใช้ robots.txt เพื่อแนะนำให้ Bot เน้นเก็บข้อมูลจากหน้าที่สำคัญก่อน เช่น หน้าผลิตภัณฑ์ หน้าบทความ SEO หรือหน้าบริการ แทนที่จะเสียเวลากับหน้าที่ไม่จำเป็นต่อการจัดอันดับ

ข้อดีของการใช้งานไฟล์ robots.txt

- ช่วยให้การทำงานของ Bot มีประสิทธิภาพมากขึ้น กำหนดให้เก็บข้อมูลแค่หน้าที่สำคัญจริง ๆ ทำให้ไม่ต้องเสียเวลาและ Crawl Budget ไปกับหน้าที่ไม่จำเป็น

- ปกป้องข้อมูลสำคัญบนเว็บไซต์ไม่ให้หลุดไปอยู่บนหน้าผลการค้นหา โดยเฉพาะข้อมูลส่วนตัว เช่น หน้าจัดการระบบ ข้อมูลสมาชิก หรือเอกสารภายในที่ไม่อยากให้คนทั่วไปเห็น

- แก้ปัญหาเนื้อหาซ้ำซ้อน (Duplicate Content) ที่ทำให้ประสิทธิภาพ SEO แย่ลง โดยบล็อกไม่ให้ Bot เข้าถึงหน้าที่มีเนื้อหาเหมือนๆ กัน เช่น หน้าแท็ก หน้าหมวดหมู่ หรือหน้าที่ระบบสร้างขึ้นมาเอง

- ช่วยประหยัดทรัพยากรเซิร์ฟเวอร์ เพราะ Bot ไม่ต้องเสียเวลาเข้าหน้าที่ไม่จำเป็น เว็บไซต์เลยโหลดได้เร็วขึ้น ซึ่งส่งผลดีต่อ SEO ด้วย

- ควบคุมการแสดงไฟล์ต่าง ๆ ในผลการค้นหาได้ตามต้องการ ไม่ว่าจะเป็นรูปภาพ วิดีโอ หรือไฟล์เอกสาร คุณเลือกได้ว่าอยากให้ไฟล์ไหนแสดงผลหรือไม่แสดงผลในการค้นหา

- ทำให้ Bot เจอไฟล์ Sitemap ได้ง่ายขึ้น เพราะ robots.txt เป็นไฟล์แรกที่ Bot จะมาอ่าน ถ้าใส่ตำแหน่ง Sitemap ไว้ตรงนี้ Bot ก็จะรู้เลยว่าเว็บไซต์คุณมีโครงสร้างยังไง

- กันไม่ให้หน้าที่ไม่สำคัญไปโผล่ในผลการค้นหา เช่น หน้าขอบคุณหลังทำรายการ หรือหน้าชั่วคราวต่าง ๆ ซึ่งถ้าปล่อยไว้ Google อาจมองว่าเว็บคุณมีหน้าไม่มีคุณภาพเยอะ

- จัดระเบียบเว็บไซต์ให้เป็นระบบ โดยกันไม่ให้ Bot เข้าถึงไฟล์ระบบ ไฟล์ชั่วคราว หรือหน้าที่กำลังทำอยู่ ช่วยให้การทำงานเป็นระเบียบและมีประสิทธิภาพมากขึ้น

สอนวิธีสร้างและแก้ไขไฟล์ robots.txt

การสร้างไฟล์ robots.txt นั้นไม่ได้ยุ่งยากอย่างที่คิด คุณสามารถใช้โปรแกรมแก้ไขข้อความพื้นฐานอย่าง Notepad หรือ TextEdit ได้ แต่ที่สำคัญคือต้องบันทึกในรูปแบบ UTF-8 เพื่อให้ Search Engine Bot อ่านและเข้าใจคำสั่งได้อย่างถูกต้อง หลีกเลี่ยงการใช้โปรแกรมประมวลผลคำ เพราะอาจเพิ่มอักขระพิเศษที่ทำให้ไฟล์ทำงานผิดพลาดได้

ขั้นตอนการสร้างไฟล์ robots.txt

- เปิดโปรแกรม Notepad หรือ TextEdit บนคอมพิวเตอร์

- เริ่มเขียนคำสั่งโดยระบุ User-agent เพื่อกำหนดว่าคำสั่งนี้ใช้กับ Bot ตัวไหน

- เขียนคำสั่ง Allow หรือ Disallow เพื่อกำหนดสิทธิ์การเข้าถึง

- บันทึกไฟล์ในรูปแบบ UTF-8 และตั้งชื่อว่า “robots.txt” เท่านั้น

- อัปโหลดไฟล์ไปที่โฟลเดอร์หลักของเว็บไซต์ (Root Directory)

สิ่งที่ต้องระวังในการสร้างไฟล์ robots.txt

- เว็บไซต์หนึ่งมีได้เพียง 1 ไฟล์ robots.txt เท่านั้น

- ไฟล์ต้องอยู่ในโฟลเดอร์หลักเสมอ เช่น https://www.example.com/robots.txt

- คำสั่งต้องเขียนแยกบรรทัด และระวังเรื่องการใช้ตัวพิมพ์เล็ก-ใหญ่

- สามารถใช้เครื่องหมาย # เพื่อเพิ่มคำอธิบายในไฟล์ได้

การทดสอบหลังสร้างไฟล์ robots.txt

- เข้าเว็บไซต์ผ่าน Browser แบบ Private Mode

- พิมพ์ URL ของไฟล์ robots.txt เพื่อตรวจสอบว่าเข้าถึงได้

- ใช้เครื่องมือตรวจสอบ robots.txt ใน Google Search Console (GSC)

- แก้ไขหากพบข้อผิดพลาดและทดสอบซ้ำจนกว่าจะทำงานได้ถูกต้อง

วิธีตรวจเช็ก robots.txt ผ่าน GSC

GSC หรือ Google Search Console คือเครื่องมือ SEO พื้นฐานที่คุณไม่ควรพลาด และยังเป็นเครื่องมือที่ช่วยให้คุณสามารถตรวจสอบการทำงานของไฟล์ robots.txt ได้อย่างมีประสิทธิภาพด้วย ทำให้คุณมั่นใจได้ว่าคำสั่งที่กำหนดนั้นทำงานถูกต้องตามที่ต้องการ ไม่มีการบล็อกหน้าสำคัญโดยไม่ตั้งใจ หรืออนุญาตให้เข้าถึงหน้าที่ควรปิดกั้น

- เข้าสู่ระบบ Google Search Console ด้วยบัญชี Google ของคุณ

- เลือกเว็บไซต์ที่ต้องการตรวจสอบจากรายการ Property

- คลิกที่เมนู “Settings” (การตั้งค่า) ทางด้านซ้าย

- เลือก “Crawling” (การคลานข้อมูล) และคลิกที่ “robots.txt Tester”

- ป้อน URL ที่ต้องการทดสอบในช่องทดสอบ

- เลือกประเภทของ User-agent ที่ต้องการตรวจสอบ เช่น Googlebot, Googlebot-Image

- กดปุ่ม “Test” เพื่อดูผลการทดสอบ

- สีเขียว – หน้าเว็บนั้นสามารถเข้าถึงได้

- สีแดง – หน้าเว็บถูกบล็อกไม่ให้เข้าถึง

- แสดงคำสั่งใน robots.txt ที่มีผลต่อ URL นั้น ๆ

- แจ้งเตือนหากพบข้อผิดพลาดในการเขียนคำสั่ง

หากพบข้อผิดพลาด คุณสามารถแก้ไขคำสั่งได้ทันทีในหน้าทดสอบ และทดลองซ้ำจนกว่าจะได้ผลลัพธ์ตามที่ต้องการ ก่อนนำไปปรับใช้กับไฟล์ robots.txt จริงบนเว็บไซต์

ข้อจํากัดของไฟล์ robots.txt

การใช้งานไฟล์ robots.txt มีข้อจำกัดสำคัญที่คุณควรทราบก่อนนำไปใช้ เพราะบางครั้งอาจไม่สามารถป้องกันการเข้าถึงข้อมูลได้อย่างสมบูรณ์ตามที่คุณต้องการนั่นเอง

ข้อจำกัดแรกของ robots.txt คือไม่ใช่ทุก Bot จะเชื่อฟังคำสั่งใน robots.txt แม้ว่า Googlebot และ Bot ดัง ๆ จะทำตามกฎที่เราตั้งไว้ แต่ก็มี Bot อีกมากมายที่อาจเพิกเฉยและเข้าถึงข้อมูลที่เราไม่ต้องการให้เข้าถึงได้ ถ้าคุณมีข้อมูลสำคัญที่ต้องปกป้องจริง ๆ ควรใช้วิธีอื่นร่วมด้วย เช่น ตั้งรหัสผ่าน หรือใช้ระบบยืนยันตัวตน

ปัญหาที่พบบ่อยอีกอย่างหนึ่งของ robots.txt คือแม้คุณจะบล็อกไม่ให้ Bot เข้าถึงหน้าเว็บได้ แต่หากมีเว็บอื่นลิงก์มาที่หน้านั้น Google ก็อาจเอาข้อมูลจากเว็บที่ลิงก์มาไปแสดงในผลการค้นหาได้ ทั้งข้อความในลิงก์และคำอธิบายต่าง ๆ ถ้าไม่อยากให้หน้าเว็บโผล่ในผลการค้นหาเลย คุณต้องใช้วิธีอื่นเพิ่ม เช่น ใส่แท็ก noindex หรือตั้งรหัสผ่านป้องกันไว้จะดีกว่า

และเรื่องสุดท้ายที่ต้องระวังคือ Bot แต่ละตัวอาจตีความคำสั่งไม่เหมือนกัน คำสั่งที่ใช้ได้ผลกับ Bot หนึ่งอาจไม่ได้ผลกับอีก Bot หนึ่ง ทำให้การควบคุมการเข้าถึงอาจไม่เป็นไปตามที่เราตั้งใจ ดังนั้นถ้าคุณมีข้อมูลสำคัญที่ต้องปกป้อง แนะนำให้ใช้ robots.txt ร่วมกับวิธีป้องกันอื่น ๆ เสมอ จะได้มั่นใจว่าข้อมูลของคุณปลอดภัยจริง ๆ

รวมคำสั่งและสคริปต์ robots.txt ที่คุณไม่ควรพลาด

ก่อนที่จะเริ่มเขียนคำสั่ง robots.txt คุณควรเข้าใจส่วนประกอบหลัก ๆ ก่อน โดย User-agent คือการระบุว่าคำสั่งนี้จะใช้กับ Bot ตัวไหน ถ้าใส่เครื่องหมาย * หมายถึงใช้กับ Bot ทุกตัว หรือจะระบุเจาะจงเช่น Googlebot ก็ได้ ส่วน Disallow ใช้สำหรับห้ามไม่ให้ Bot เข้าถึงส่วนที่ระบุ เช่น Disallow: /admin/ คือห้ามเข้าโฟลเดอร์ admin ในขณะที่ Allow ใช้สำหรับอนุญาตให้เข้าถึงได้ ซึ่งมักใช้ยกเว้นบางส่วนที่อยู่ในโฟลเดอร์ที่ถูกห้ามไว้ก่อนหน้า

| ไม่ให้ Bot เข้าถึงทั้งเว็บไซต์ |

User-agent: * Disallow: / |

| ห้ามเข้าถึงเฉพาะบางโฟลเดอร์ |

User-agent: * Disallow: /admin/ Disallow: /private/ |

| อนุญาตให้ Bot เข้าถึงเฉพาะบางส่วน |

User-agent: * Disallow: / Allow: /blog/ |

| คำสั่งห้ามเข้าถึงเฉพาะไฟล์รูปภาพ |

User-agent: Googlebot-Image Disallow: /images/ |

| คำสั่งห้ามเข้าถึงเฉพาะไฟล์ PDF และ DOC |

User-agent: * Disallow: /*.pdf$ Disallow: /*.doc$ |

| คำสั่งระบุตำแหน่ง Sitemap ของเว็บไซต์ | Sitemap: https://www.example.com/sitemap.xml |

สรุป

robots.txt คือไฟล์ที่ช่วยกำหนดกฎการเข้าถึงข้อมูลสำหรับ Search Engine Bot โดยคุณสามารถระบุว่าส่วนใดของเว็บไซต์ที่ต้องการให้ Bot เข้าถึงหรือไม่เข้าถึง การตั้งค่าที่เหมาะสมจะช่วยให้เว็บไซต์มีประสิทธิภาพดีขึ้นได้ และยังช่วยให้ Google เข้าใจโครงสร้างเว็บไซต์ของคุณได้ดีกว่าเดิม นำไปสู่การเพิ่มโอกาสในการติดอันดับบนผลการค้นหา สร้าง Traffic และทำให้เว็บไซต์เติบโตขึ้น อย่างไรก็ตาม การใช้งาน rrobots.txt ควรระมัดระวังและตรวจสอบให้ดี เพื่อไม่ให้เกิดการบล็อกหน้าสำคัญโดยไม่ตั้งใจ เพราะอาจส่งผลเสียต่อเว็บไซต์และ SEO ในภายหลังได้

ANGA Mastery แพลตฟอร์มแห่งการเรียนรู้! โดยผู้เชี่ยวชาญจากเอเจนซี่รับทำ SEO และ Perfomance Marketing ชั้นนำในไทย นอกจากความรู้ดี ๆ ด้านการตลาดออนไลน์และโลกธุรกิจแล้ว เรายังเปิดสอนคอร์สเรียนการตลาดในด้านต่าง ๆ มากมาย